以下の記事は、Qiitaの@ryotanatsumeさんが記述した「最新deep learningを用いて、一枚全身画像から人を復元してみた」の紹介記事です 。

はじめに

こんにちは、私はestieでAIアルゴリズム開発をしているなつめです。

普段は学生としてコンピュータビジョン系の研究を行なっています。

本記事では、estieの業務と直接は関係ありませんが、折角の機会なので私の研究していたdeep learning技術である「一枚の画像から人の三次元形状復元」について紹介していきます。

三次元復元の研究目的・背景

近年、ARやVRなどの没入型の映像体験が流行しています。

それらの映像に必要なCDCGコンテンツを製作するためには、現実世界の三次元物体をデジタル化する必要があります。

特に、着衣人物の3DCG化の場合は、何十台ものカメラを用いた緻密なスキャン装置や、複雑かつ長時間の撮影作業が必要となります。

そこで、一枚の画像から深層学習を用いて着衣人物の全身を3DCG化をしようというのが、大きな目的です。

今回やったこと

実際に、iPhoneで撮影した着衣人物の画像一枚から、PIFuと呼ばれる手法を使って人の三次元形状復元を行いました。

さらに、復元した形状を使って、何ができるかといことを紹介して行こうと思います。

実際に今回行ったことは以下の二つです。

1. 復元した三次元モデルを動かす

2. 三次元プリンティングする

PIFuと呼ばれる三次元復元手法

この研究は私がICCV2019という国際会議で発表した内容で、Deep Learningを用いて学習することで二次元画像から三次元形状を復元するといった研究です。

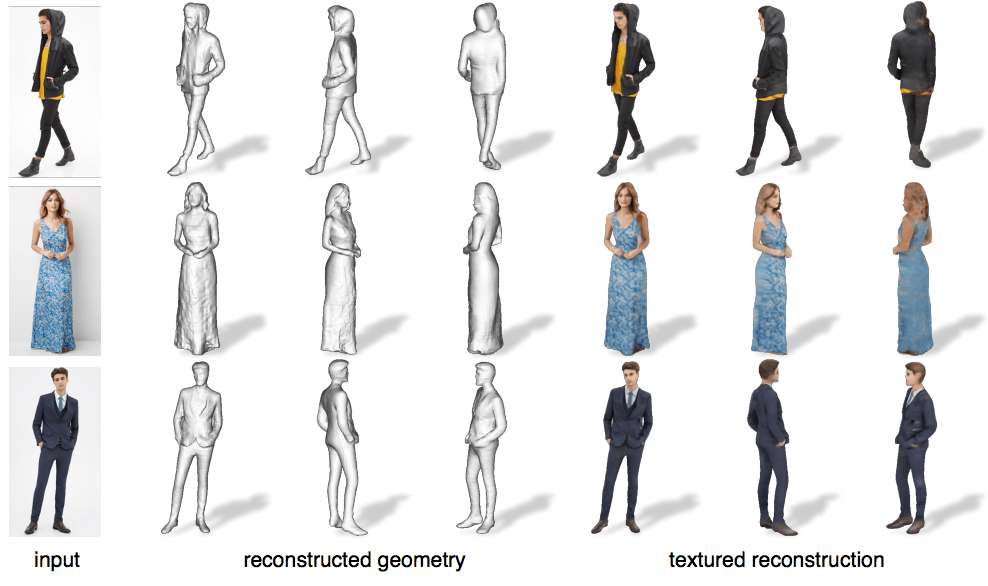

論文中の結果がこちらです。inputの列が入力画像、reconstructed geometoryの三列が復元された形状、textured reconsturctionの三列が復元された形状と色情報を示した図です。

実際に復元してみた